En la previa a su Conferencia Mundial de Desarrolladores de 2025 (WWDC), Apple publicó un pretencioso paper que plantea la teoría de que los modelos de inteligencia artificial que el usuario promedio utiliza, sólo está imitando.

"La ilusión del pensamiento": la teoría de Apple que derrumba conceptos sobre la IA

Un paper de la empresa de tecnología plantea la posibilidad de que estas herramientas no están razonando y sólo se limitan a copiar. Cuáles fueron las pruebas realizadas.

Bajo el título “La ilusión del pensamiento: comprender las fortalezas y limitaciones de los modelos de razonamiento a través de la lente de la complejidad del problema”, Parshin Shojaee, Iman Mirzadeh, Keivan Alizadeh, Maxwell Horton, Samy Bengio y Mehrdad Farajtabar intentaron bajar a tierra el concepto que pone un poco el pies sobre el acelerador de la revolución.

El acostumbramiento a recibir noticias constantemente superadoras sobre el desarrollo y avance de la IA, fue coartada por este documento basado una serie de pruebas realizadas a modelos de razonamiento grandes y modelos de lenguaje grandes.

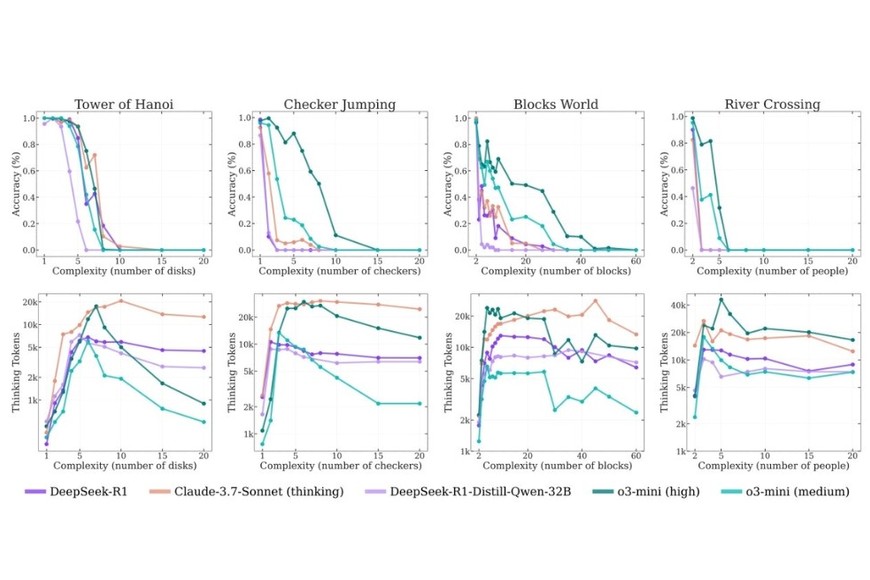

Mediante el testeo con juegos matemáticos y de lógica clásicos como la Torre de Hanoi, River Crossing, Conway’s Soldiers o Blocks World, los investigadores determinaron de forma indirecta que ambos tipos de modelos no alcanzan la condición de “razonamiento”.

Según RAE, podemos definir al “pensamiento” como “potencia o facultad de pensar” o “acción y efecto de pensar”. Por el lado del término “razonar”, lo define como “ordenar y relacionar ideas para llegar a una conclusión” o “exponer razones o argumentos”.

Los ejemplos de Apple mediante las pruebas a modelos de IA como Claude de Anthropic, los modelos de OpenAI, DeepSeek R1 y los modelos de pensamiento de Google indican que dichas acciones de pensamiento no son alcanzadas. Al menos hasta junio de 2025.

Qué dice el paper

El documento oficial de Apple indica que los modelos de vanguardia “aún no desarrollan capacidades generalizables de resolución de problemas, y su precisión se reduce a cero más allá de ciertas complejidades en diferentes entornos”.

“Las evaluaciones actuales se centran principalmente en puntos de referencia matemáticos y de codificación establecidos, haciendo hincapié en la precisión de la respuesta final. Sin embargo, este paradigma de evaluación a menudo sufre de contaminación de datos y no proporciona información sobre la estructura y la calidad de los rastros de razonamiento”, detalla el paper sobre la motivación de las pruebas.

Sobre algunas conclusiones, el texto agrega: “Mostramos que los LRM de frontera se enfrentan a un colapso total de la precisión más allá de ciertas complejidades. Además, exhiben un límite de escalamiento contra-intuitivo: su esfuerzo de razonamiento aumenta con la complejidad del problema hasta cierto punto, luego declina a pesar de tener un presupuesto de tokens adecuado”.

“Descubrimos que los modelos de razonamiento grandes tienen limitaciones en el cómputo exacto: no usan algoritmos explícitos y razonan de manera inconsistente entre los acertijos. También investigamos los rastros de razonamiento con más profundidad, estudiando los patrones de las soluciones exploradas y analizando el comportamiento computacional de los modelos, arrojando luz sobre sus fortalezas, limitaciones y, en última instancia, planteando preguntas cruciales sobre sus verdaderas capacidades de razonamiento”, concluye la exposición de Apple.

¿La puede superar o reemplazar al humano?

De momento, este documento plantea la posibilidad de que la idea de una IA superinteligente que “supere al humano” se encontraría limitada ante el formato de trabajo que estas utilizan.

La imitación de patrones y la ausencia de una acción cercana al pensamiento indicaría que no hay un pensamiento que desarrollar, según Apple.

La búsqueda de la “divinización” de la IA o una mirada antropomórfica ha sido cuestionada por autores como Emily M. Bender y Alex Hanna, quienes limitan la expectativa de dichas herramientas en consonancia con la empresa de la manzana.

Rodrigo Echeveste, investigador del CONICET y la Universidad Nacional del Litoral (UNL) habló el pasado viernes 6 de mayo en la tercera edición del Tendencias TECH de la ciudad de Santa Fe y respondió sobre el concepto de “reemplazo” de la IA.

“La IA va a reemplazar tareas específicas. El desafío es detectar cuáles tareas es correcto que se reemplacen. El humano no se reemplaza. Las tareas que requieren creatividad siguen atadas a lo humano”, indicó Echeveste.

Darío Ivanoff, durante el mismo evento, se refirió en un pasaje de su exposición a una idea similar: “Mediante el concepto de ‘inteligencia aumentada’, creemos que los agentes pueden procesar grandes volúmenes de datos, pero siempre el humano aportando la parte creativa”.

Los dramas de Apple

Este paper no llega en un contexto completamente aisladas, además de la WWDC que casi coincide en la fecha de publicación, Apple atraviesa una particular crisis en torno a la inteligencia artificial.

A un año de la edición previa de la Conferencia, cuando se presentó Apple Intelligence, un sistema que engloba todos los dispositivos de la marca mediante la IA, el mismo aún no funciona de forma efectiva.

La base de la salida al mercado de su última versión de iPhone se sostenía sobre el concepto de Apple Intelligence, argumentando que él mismo era el adecuado para soportar el sistema. Hasta el momento no se concretó al 100%, al igual que la caída del costoso Apple Vision Pro.

El documento completo

Dejanos tu comentario

Los comentarios realizados son de exclusiva responsabilidad de sus autores y las consecuencias derivadas de ellos pueden ser pasibles de las sanciones legales que correspondan. Evitar comentarios ofensivos o que no respondan al tema abordado en la información.